Deep Learning[20]

深度学习 - 网络的优化 Optimisation for Training Deep Networks

深度学习 - 网络的优化 Optimisation for Training Deep Networks 深度学习问题需要一个损失函数,我们的目标就是通过优化算法来最小化损失,即最小化目标(损失)函数。需要注意的是,优化和深度学习的本质目标有差异,优化关注的是最小(最大)化目标,深度学习更关注模型。

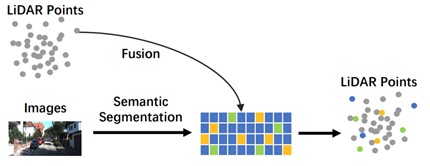

多传感器融合——后融合

多传感器融合的方案可以分成前融合(Early Fusion)方案和后融合(Late Fusion)方案。 前融合也叫特征级融合,不同传感器的数据会在特征级别进行合并,也就是说,不同模态的数据经过处理和合并后会得到一个特征集合。一般来说,每个模态数据的特征会被分别提取,然后被提取到的特征会被合并为一个

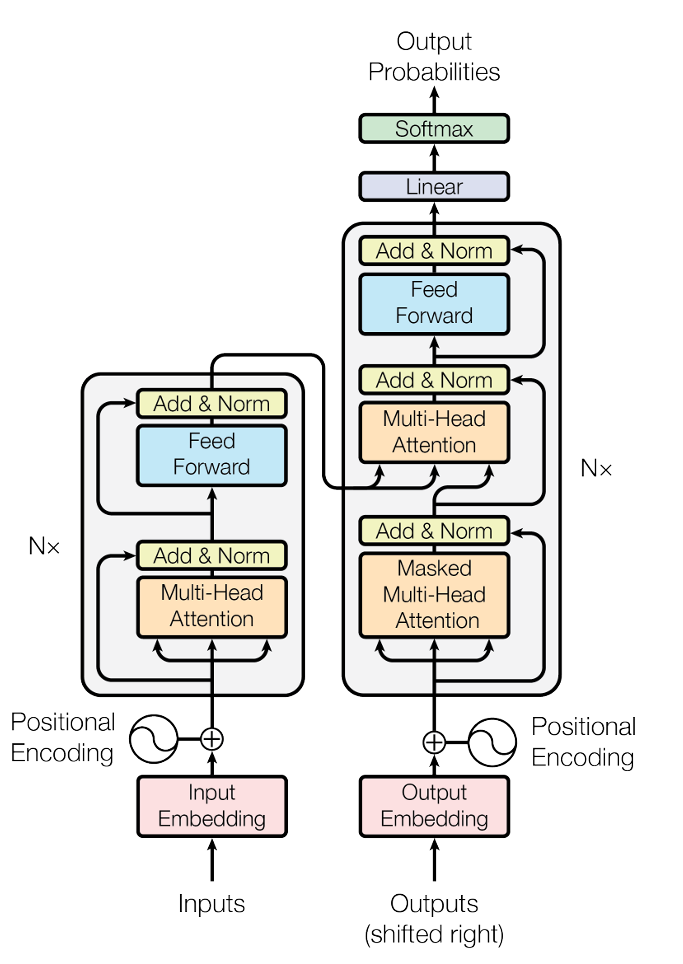

学习Transformer

Transformer在谷歌2017年的论文 [1706.03762] Attention Is All You Need 中首次被提出,主要用于NLP(Natuarl Language Processing,自然语言处理)的各项任务。 后来在CV领域,研究者们基于Transformer架构开展了一

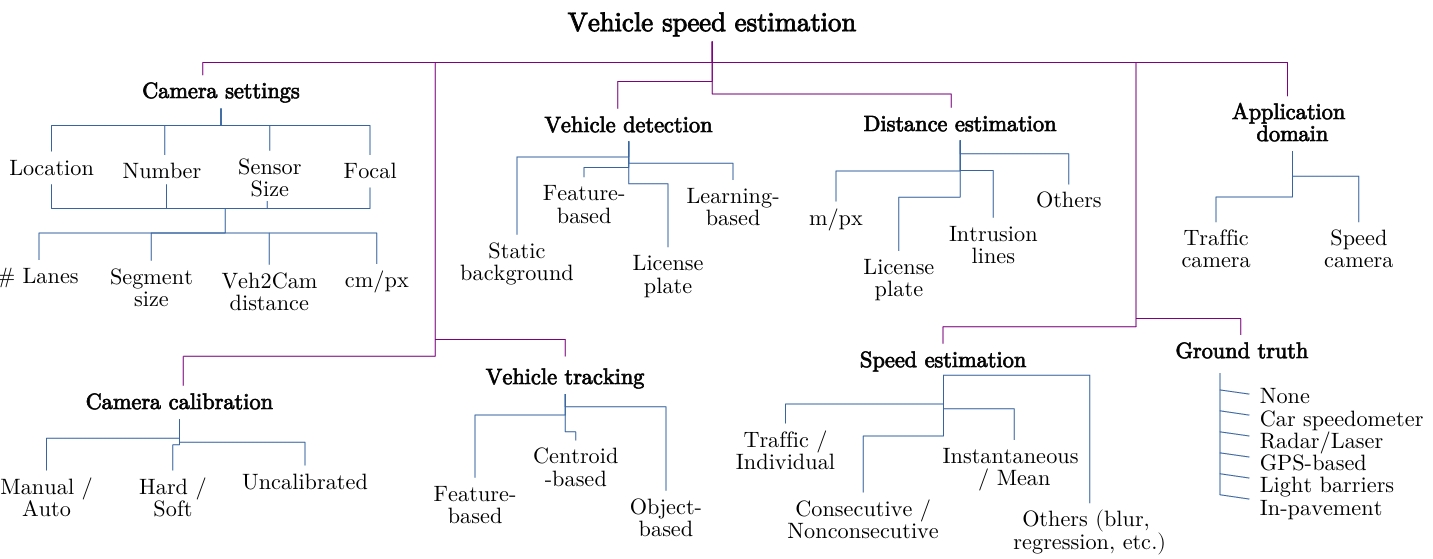

单目相机的相对速度估计

前言 单目相机的目标距离估计本身就已经充满了挑战,那么目标的(相对)速度估计也必然是十分困难... 目前单目相机的相对速度估计算法可以分成两类:传统方法和深度学习方法。没错,什么任务都可以深度学习。 传统方法中,最经典的是Mobileye在2003年的一篇论文中提出的算法。这个算法包含目标距离和速度

道路目标流量统计算法

实现流量统计算法有两个前提: 能够实现目标检测,最基本的前提,必须能够识别到视频帧中的车辆和行人。 能够进行目标跟踪,在检测的基础上,为目标分配一个唯一的ID。流量计数依赖于目标的唯一ID。 目标检测算法以YOLO系列为例。 跟踪算法以ByteTrack跟踪结果为例。将检测结果objects作为By

面向自动驾驶的端到端感知技术及发展趋势

摘要: 近年来,随着深度学习技术的发展和硬件算力的不断增强,自动驾驶技术越来越多的应用在各种场景。包括视觉感知、激光雷达感知和多传感器融合感知技术在这些年都得到了迅速发展。本文首先回顾了近年来自动驾驶感知技术的相关工作,然后介绍了相关工作所用到的方法和技术。随后整理并介绍了自动驾驶感知所需的数据集和

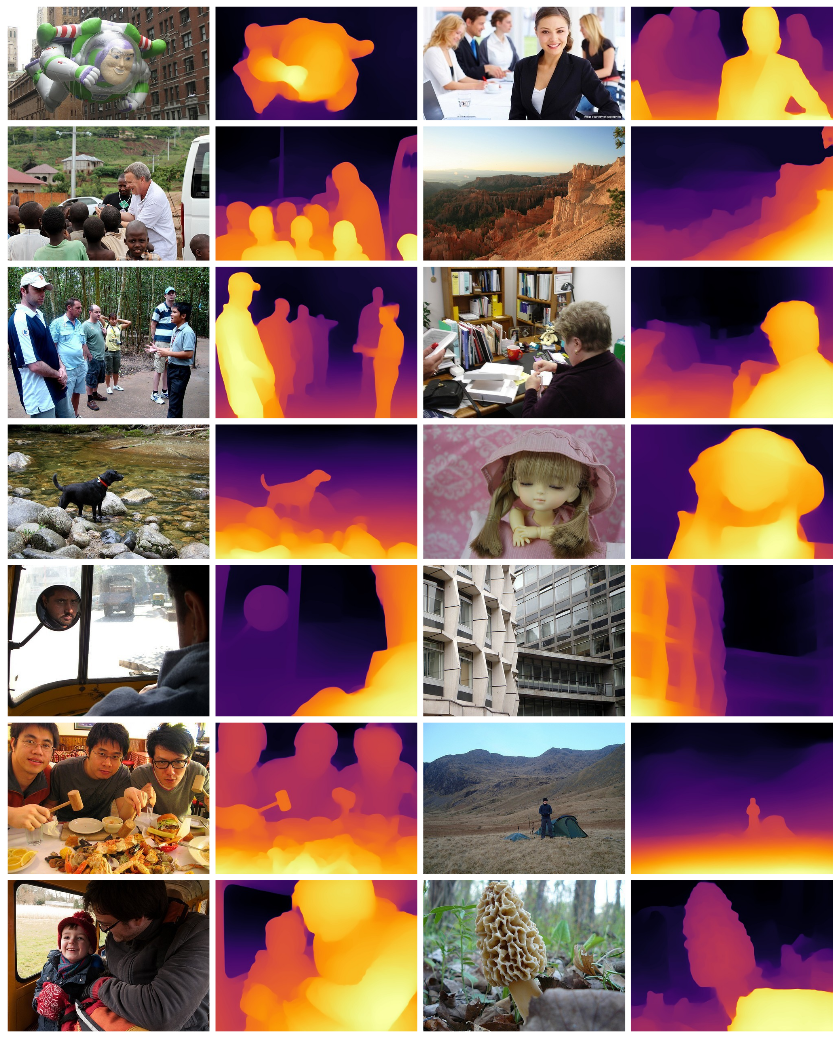

单目相机的深度图,以及绝对深度和相对深度

深度图 深度图 (Depth Image, Depth Map),将图像中的每个像素都编码为相机到场景中某个点的距离,可以提供图像中物体的空间信息。深度图通过坐标转换可以转换为点云数据,organized点云也可以转换为深度图数据。 绝对深度和相对深度 绝对深度:空间中物体和相机间的距离,有量纲。

Jetson Orin部署Mediapipe Holistic检测

安装JDK Jetpack一般不带JDK,sudo apt install openjdk-11-jdk 装一个。 安装Bazel 针对Mediapipe这个项目,你需要使用的Bazel版本,取决于你下载的Mediapipe版本所使用的Bazel版本(有点绕,高可以,低不行)。 要问CMake能不能

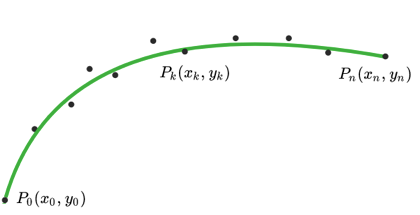

车道线的多项式曲线拟合

离散点平滑 基于优化的离散点平滑 模型检测到的车道线,最终的输出的是车道线的点坐标(x,y),这些点能够大概描述车道线在画面中的位置,但是如果想要拟合出车道线的高阶方程,可能还是不够平滑,一些离散点会影响拟合的效果。 优化变量:车道线点坐标(x_i,y_i) 优化目标有三个,分别是平滑度、长度和相对

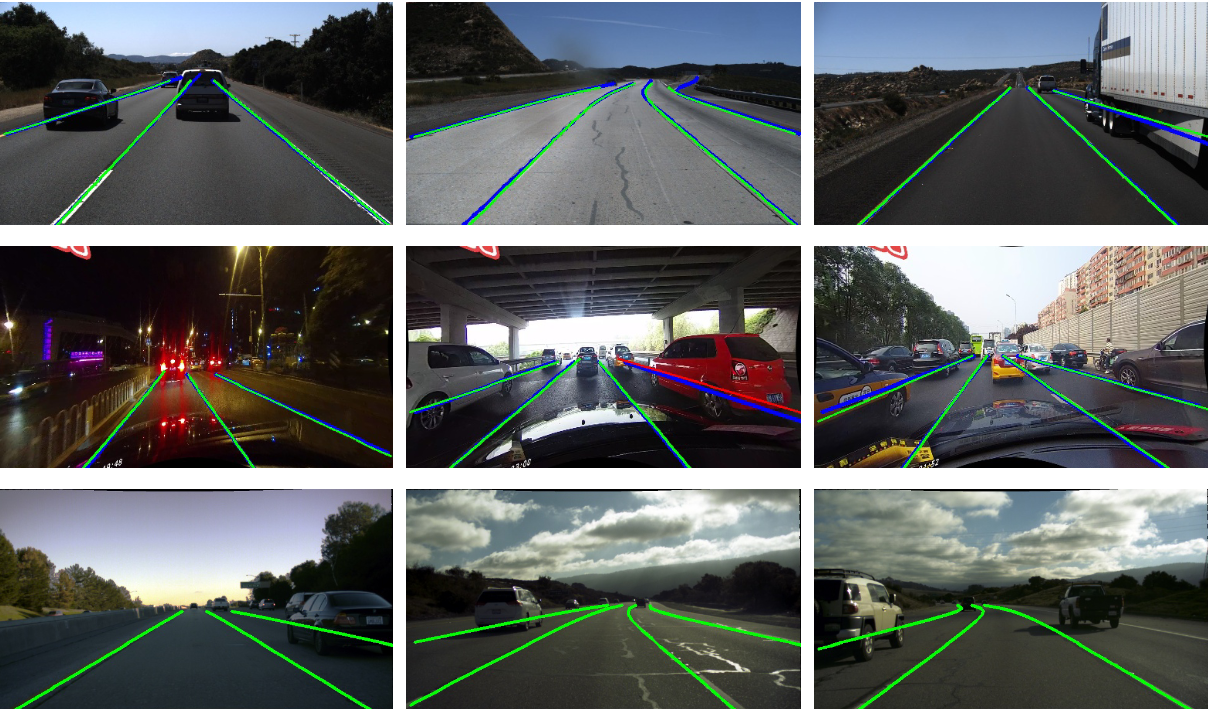

车道线检测功能综述【深度学习方法】

深度学习方法 车道线检测常用数据集见 FunnyWii's Zone 车道线检测功能综述【传统方法】 基于分割的方法 利用语义分割或实例分割方法来区分图像中的车道线与其他物体或背景。这种方法将车道线检测问题转化为一个像素级分类问题。这种方法会将场景图片的每一个车道线像素都进行分类,判断该像素是否属于