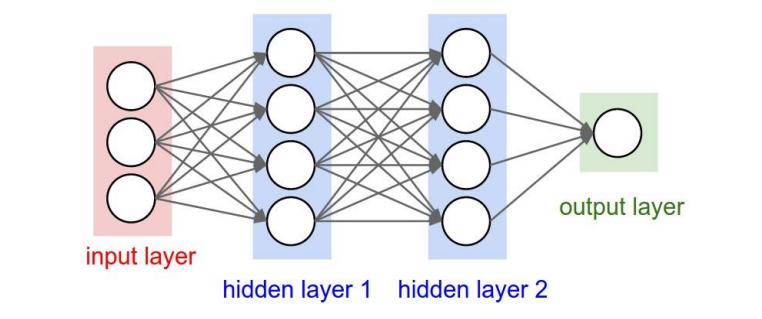

Deep Learning

Git

0

Gstreamer

1

电子产品

0

玩儿

1

手串

1

文玩

1

LLM

1

UDP

1

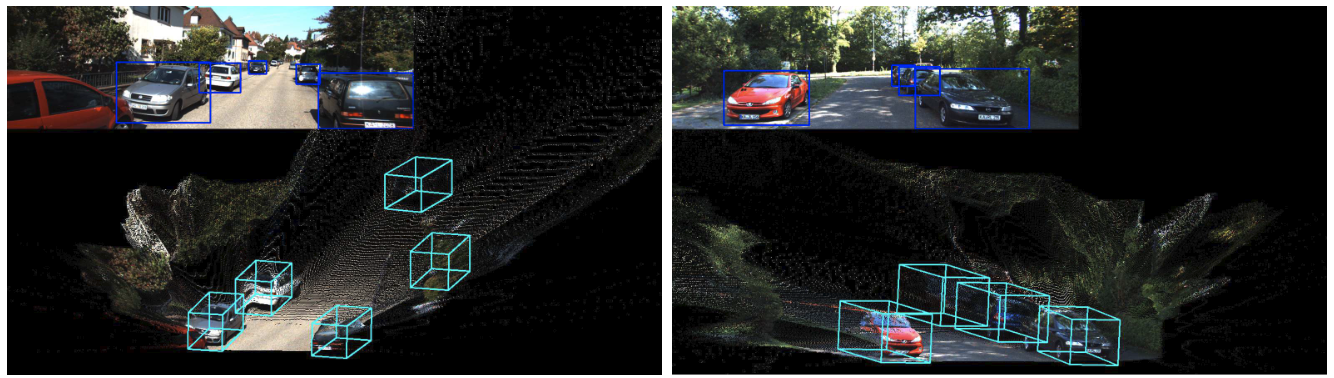

LiDAR

5

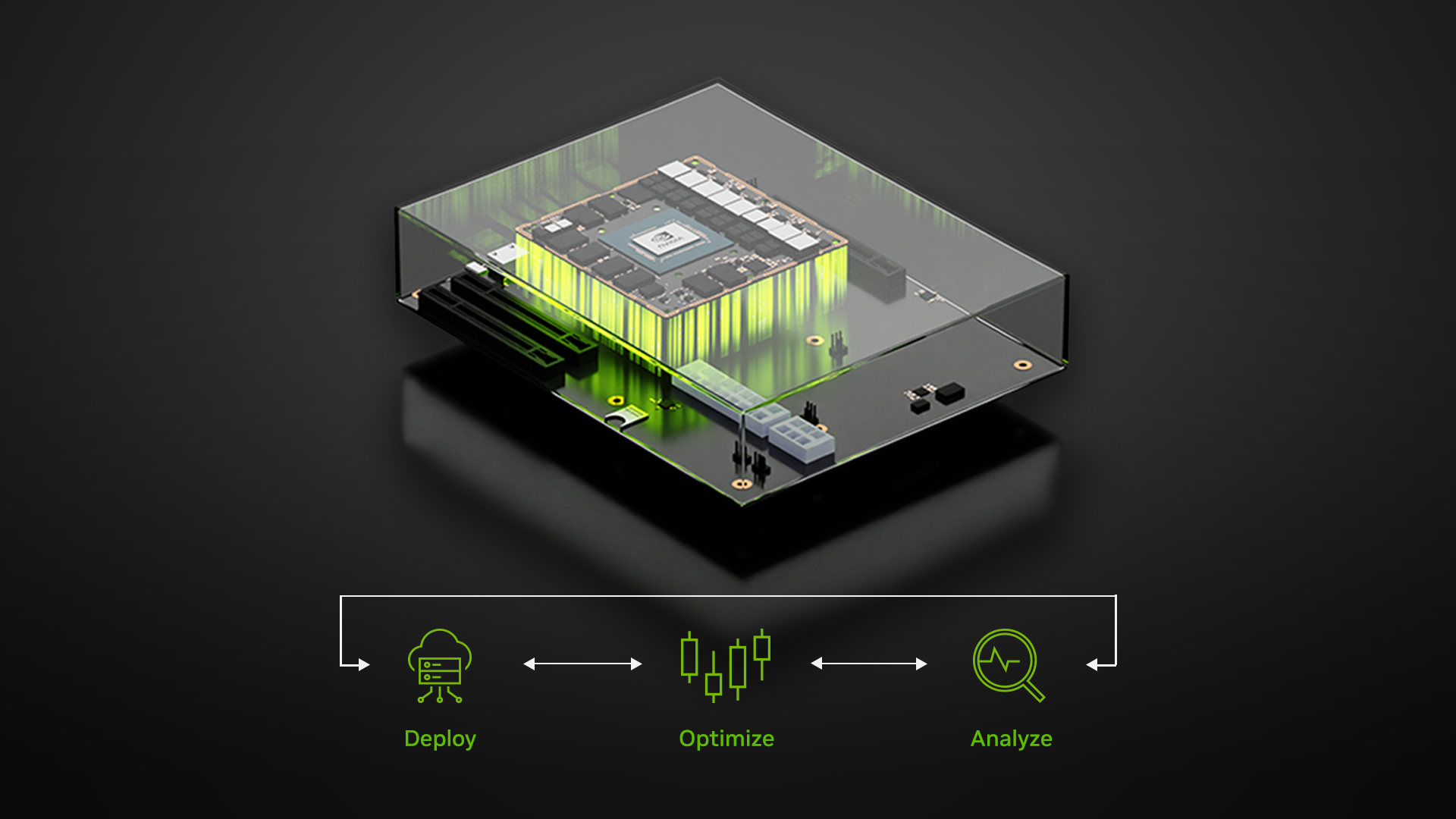

Jetson

4

Docker

2

CUDA

8

ROS

9

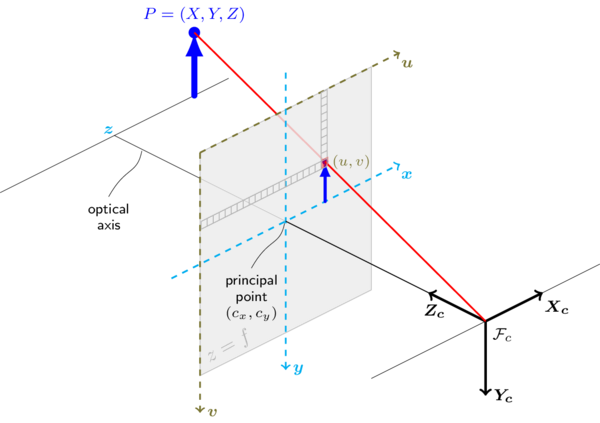

Computer Vision

15

杂

1

にじげん

1

PCL

4

OpenCV

26

Deep Learning

18

Operation System

6

Linux

23

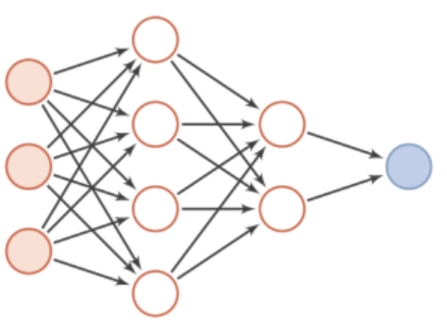

Machine Learning

10

Python

8

Machine Vision

6

C++

29

Math

3

Algorithm

43

office

0

Windows

1

Point Cloud

9

MATLAB

4

Halo

0